Deepfake phishing: la evolución del engaño

https://ish.com.br/en/blog/deepfake-phishing-o-que-e-como-funciona-como-se-proteger/

Estado de la cuestión

A principios de este año, el mundo de una estudiante universitaria coreana se vino abajo cuando recibió un mensaje en su teléfono: una imagen sexualmente explícita de sí misma que ella nunca se había sacado. Allí estaba ella, con su cara injertada digitalmente en el cuerpo de otra persona.

Las imágenes eran deepfakes, una tecnología de IA entrenada con material fotográfico, de vídeo o de audio real, diseñada para engañar y humillar. Pero el estudiantado no está solo en esto; hoy en día, la crisis de los deepfakes se extiende por escuelas, lugares de trabajo y nuestras vidas personales. Este año se ha producido un aumento de casi el 60% en los ataques de phishing, en parte debido a los deepfakes de IA. Y lo que es aún más preocupante, estos ataques están alterando nuestras percepciones y nuestra capacidad para distinguir la ficción de la realidad.

Este aumento de los deepfakes y del phishing de audio puede relacionarse con la creciente accesibilidad de herramientas como D-ID y ElevenLabs, que facilitan la clonación de identidades. En sólo ocho minutos, cualquiera puede crear un vídeo deepfake convincente. Cuando la manipulación se ha vuelto tan fácil, el principal reto consiste en verificar la autenticidad. Para entender por qué estas estafas engañan a todo el mundo -desde ejecutivos de alto nivel a empleados rasos- recurrimos a los principios de persuasión del psicólogo Robert Cialdini. Principios como la autoridad, la influencia social y la urgencia suelen estar presentes en estas estafas, provocando el pensamiento automático de los más precavidos. No es de extrañar que el error humano sea la causa de la mayoría de los incidentes cibernéticos; estas tácticas explotan nuestros sesgos cognitivos, aprovechando los puntos ciegos que surgen de las decisiones rápidas e impulsadas por las emociones.

A medida que la verificación de contenidos digitales se vuelve más compleja, recurrimos instintivamente a la tecnología en busca de ayuda. Las audaces afirmaciones de numerosos «detectores de IA» están a la orden del día, pero con herramientas que pueden eliminar las marcas de agua de IA de las imágenes y profesores de secundaria que luchan por detectar los deberes generados por IA, las soluciones realmente eficaces escasean. La detección automática sigue siendo incoherente e inaccesible, y a nadie sorprenderá que los actores maliciosos se aprovechen de esta carencia. Hasta que la tecnología se ponga al día en cuanto a detección y protección, nos vemos abandonados a nuestra suerte a la hora de tomar decisiones en tiempo real bajo una gran presión, sin una red de seguridad fiable. Pero ser conscientes de nuestros sesgos cognitivos puede mejorar significativamente nuestra precisión en la toma de decisiones, especialmente en situaciones de estrés. Al comprender y anticipar nuestras vulnerabilidades cognitivas, podemos equiparnos para reconocer y responder a estas tácticas de manipulación.

Cortocircuitando el cerebro

No se trata de un fallo humano; nuestras mentes, cableadas para ser eficientes, están siendo manipuladas de formas a las que somos naturalmente vulnerables. Empecemos con tres sesgos cognitivos que nos afectan a todos, ya sea en las elecciones personales cotidianas o en las decisiones empresariales de alto riesgo.

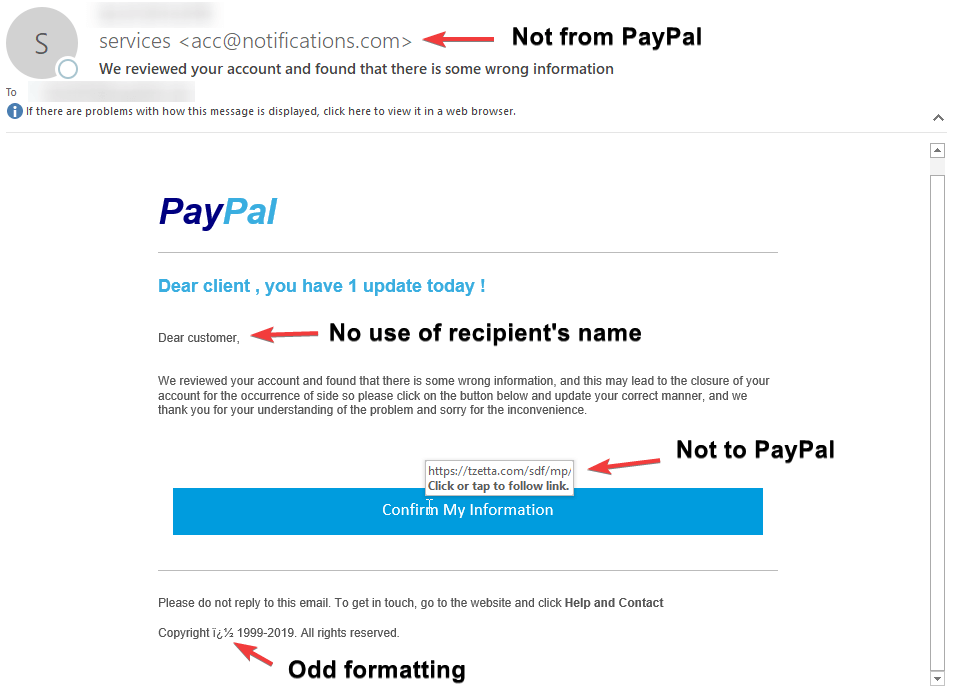

- Consideremos el caso de un hombre de Chicago que perdió 50.000 dólares tras caer en un aviso urgente por correo electrónico que parecía proceder de PayPal y que decía que su cuenta estaba a punto de verse comprometida debido a unas transacciones sospechosas. De forma apresurada, se le instó a hacer clic en un enlace adjunto para volver a introducir los datos de su cuenta bancaria. En ese momento, incurrió en un episodio de visión de túnel: su concentración en la tarea urgente le impidió ver otros indicios de estafa, como la URL sospechosa y el correo electrónico del remitente.

- Un hombre de 72 años de Kerala (India) recibió mensajes de WhatsApp, audios y hasta una videollamada de un supuesto antiguo colega pidiéndole ayuda financiera para una urgencia médica. Consumido por la preocupación y convencido de que se trataba de alguien real y conocido, transfirió los fondos, sin darse cuenta de que las emotivas súplicas eran en realidad fabricadas por un estafador. El incidente ilustra otro sesgo común: la heurística del afecto, en la que nuestras emociones dominan nuestros juicios.

- Finalmente, tenemos el caso de un trabajador financiero que asiste a una videollamada con varios altos ejecutivos de una empresa multinacional. Le pidieron que transfiriera inmediatamente 25 millones de dólares. Su confianza en las figuras de autoridad que percibía le llevó a enviar el dinero, pasando por alto cualquier incoherencia que observara. Este es un claro ejemplo de sesgo de autoridad, en el que instintivamente confiamos y damos una importancia indebida a las palabras de quienes ostentan el poder.

Redirigiendo las rutas del pensamiento

Los ejecutivos y dirigentes siempre han sido los principales objetivos de las estafas de phishing, y los deepfakes agravan significativamente esta realidad. Ahora que los medios digitales permiten acceder fácilmente a imágenes y grabaciones de vídeo, crear un ataque convincente nunca ha sido tan sencillo. Aunque las defensas sistémicas contra el phishing -desde la autenticación multifactor y la detección basada en IA hasta la formación gamificada y los ciberseguros– ofrecen una valiosa protección, no está de más tener en cuenta estos pasos prácticos para mejorar la vigilancia y la detección de forma personal, fomentando así una cultura de seguridad resistente.

Reenfocar la atención para contrarrestar las tácticas que emplean la urgencia

Las estafas de phishing se basan en la urgencia o el miedo para distraernos del escrutinio de la situación. Las investigaciones demuestran que desviar deliberadamente la atención hacia señales neutras ayuda a gestionar los sesgos de atención.

Tomemos el caso reciente de un alto directivo de una empresa de ciberseguridad que fue víctima de un estafador que se hizo pasar por su director general. Armado con un mensaje de WhatsApp convincente y una grabación de audio, le presionó para que actuara en un «asunto de negocios» urgente. Pensó por un momento y se centró en las pistas que no cuadraban: hablar de información sensible en una aplicación informal y rechazar una llamada de seguimiento. En lugar de obedecer, hizo una pausa, consultó su lista de comprobación mental y comunicó el incidente a IT. Desarrollar el hábito de dar un paso atrás, incluso durante nueve segundos (un minuto o dos es incluso mejor), puede marcar una diferencia significativa. Esta pausa da tiempo a consultar una lista de verificación neutral: comprobar los datos del remitente, pasar el ratón por encima de los enlaces adjuntos o dar un paseo para refrescarse; pausar ayuda a volver a centrarse en los hechos y a gestionar la sobrecarga cognitiva.

Identificar los desencadenantes emocionales dirigidos a la compasión

Los ataques de ingeniería social se dirigen primero a nuestras emociones; cuando nuestra respuesta coincide con la intensidad de su manipulación, nuestro pensamiento se vuelve reactivo y rígido. Una estrategia más eficaz es el etiquetado emocional: nombrar conscientemente nuestras emociones para verlas como fuentes de datos transitorios. Esta práctica ayuda a reconocer lo que está en juego y permite una respuesta más racional.

Una pareja, por ejemplo, recibe una horrible llamada en la que se les informa de que los padres de él han sido tomados como rehenes. Al principio, el afectado entra en pánico, pero se detuvo un momento para reconocer que lo que estaba sintiendo era miedo. Reconoció que el pánico no salvaría a sus padres y optó por una estrategia lógica. Utilizó otro teléfono para llamarles directamente y confirmar su seguridad. Detenerse a etiquetar sus emociones le ayudó a recuperar el control emocional y a considerar las consecuencias a largo plazo frente a los beneficios a corto plazo. Al hacerlo, podemos pasar de respuestas automáticas a otras más deliberadas y conscientes.

Resistirse a la deferencia automática hacia la autoridad

En la mayoría de los incidentes, la mitad de la batalla está perdida debido a nuestra inherente confianza en la autoridad. Una buena práctica es aprovechar nuestro conocimiento compartido como herramienta de verificación. Cuando un ejecutivo de Ferrari recibió una llamada del CEO Benedetto Vigna desde un número desconocido, al principio no le dio importancia. Pero cuando la conversación se volvió confidencial, empezó a sospechar. En lugar de confiar en la autoridad de la persona que llamaba, le hizo una pregunta personal que sólo el CEO podía responder. El interlocutor guardó silencio y colgó.

Otra estrategia consiste en buscar activamente información que cuestione nuestros supuestos. Participar en la toma de decisiones colectiva puede ayudar a aplazar la fe ciega en la autoridad; esto puede hacerse consultando fuentes creíbles antes de actuar ante peticiones urgentes. La mayoría de las estafas hacen peticiones inusuales. La simple pregunta «¿Por qué me extraña esto?» puede hacernos tomar conciencia y empujarnos a comprobarlo con fuentes fiables. Esta táctica de comprobación de la credibilidad -volviendo a llamar a través de canales de confianza o verificados- mantiene a raya la desinformación y ayuda a reducir la ansiedad y la ambigüedad, y permite hacer preguntas de seguimiento. Establecer canales de comunicación transparentes dentro de una organización permite a los empleados cuestionar instrucciones dudosas o expresar sus preocupaciones sin temor a represalias. Una cultura de trabajo que fomenta el cuestionamiento, la verificación y la colaboración en la resolución de problemas crea una cultura resistente.

Los sesgos cognitivos son esenciales para nuestra toma de decisiones diaria y no pueden eliminarse, pero gestionarlos es posible. Con el tiempo, la resiliencia cognitiva, apoyada por un lugar de trabajo y una tecnología propicios, puede fortificar las organizaciones desde la base.

https://hbr.org/2024/10/phishing-attacks-are-evolving-heres-how-to-resist-them

https://ironscales.com/glossary/deepfake-phishing

https://securitybrief.com.au/story/check-point-predicts-ai-will-shape-cyber-threats-by-2025

https://psicologiaymente.com/psicologia/etiquetado-emocional